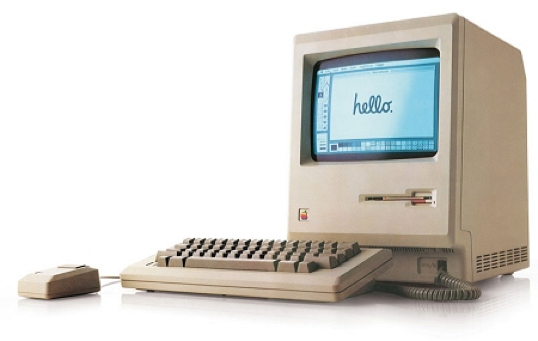

24 gennaio 1984: Apple presenta il Macintosh, primo computer di successo commerciale a utilizzare l’interfaccia grafica ed il mouse come sistema d’interazione tra l’utente e la macchina.

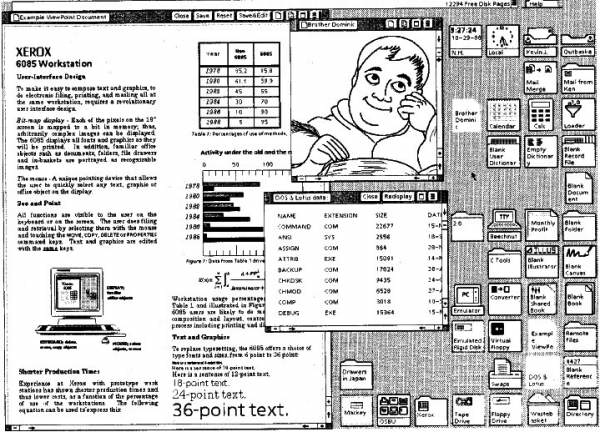

Prima ogni azione corrispondeva ad un comando scritto a mano. Per provare l’ebrezza dei “bei vecchi tempi”, aprite il Terminale dalla cartella Applicazioni>Utility del vostro Mac per avere idea di come fossero le cose prima della Gui.

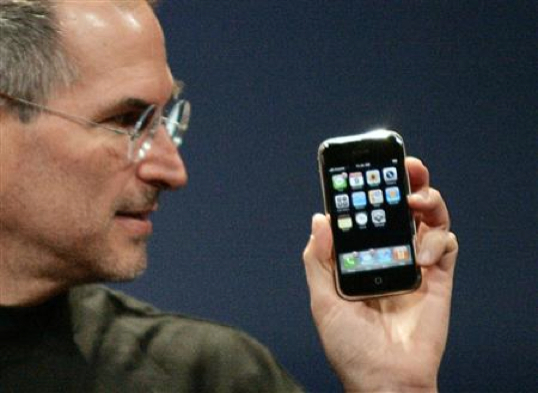

Gennaio 2007: Apple presenta iPhone, la completa rivisitazione di come dovrebbe essere un telefono secondo Steve Jobs. Da subito, però, è stato ovvio che iPhone non fosse solo un telefono. Anzi, iPhone è apparso immediatamente come un Mac da tasca con l’interfaccia tattile che telefonava, anche.

La parte telefonica, infatti, si è rivelata ben presto la ciliegina sulla torta di un prodotto il cui uso primario è il computing in mobilità. 150.000 applicazioni per iPhone ed iPod Touch, infatti, con più di 3 miliardi di download in 19 mesi rendono bene l’idea di come questo dispositivo è visto da sviluppatori e utilizzatori: un device multi-purpose, con la possibilità di espandere le sue funzioni in maniera pressoché illimitata via software, sia grazie ai programmatori di terze parti sia grazie ai continui aggiornamenti da parte di Apple al sistema operativo e alle applicazioni di base. L’unico vero limite, finora, era uno: la dimensione dello schermo. Lo schermo infatti rendeva iPhone perfetto per essere tenuto in tasca ed effettuare operazioni in estrema mobilità, ma limitava di molto le possibilità sia dal punto di vista dell’interfaccia grafica per gli sviluppatori, sia dal punto di vista dell’usabilità in certi contesti.

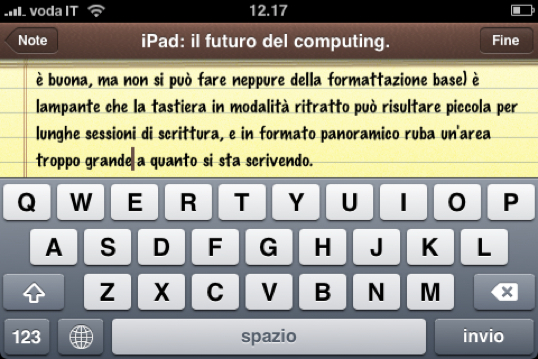

Prendiamo la scrittura. A parte la mancanza di software adatto (Note è buona, ma non si può fare neppure della formattazione base) è lampante che la tastiera in modalità ritratto può risultare piccola per lunghe sessioni di scrittura, e in formato panoramico ruba un’area troppo grande a quanto si sta scrivendo.

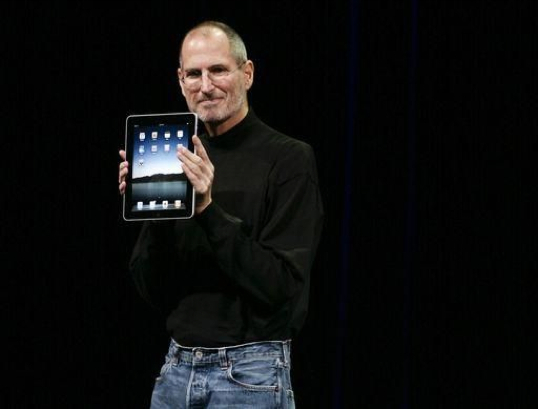

27 gennaio 2010: Apple presenta iPad.

Con iPad, invece, lo schermo è abbastanza grande da poter visualizzare una tastiera estesa delle dimensioni simili a quella dei MacBook, oltre a fornire una versione di Pages riscritta ed ottimizzata per lo strumento su cui deve essere utilizzata.

È tutta qui, l’innovazione di iPad? Assolutamente no. L’innovazione sta nel aver fatto una scelta importante, ovvero l’uso di iPhone OS come sistema operativo dell’iPad. Dal punto di vista tecnico, in iPad Apple avrebbe potuto benissimo mettere una versione “full” di Mac OS X. Le dimensioni e la risoluzione dello schermo lo avrebbero permesso (qualcuno ricorda il PowerBook 12″?), creando qualcosa di identico ai Tablet Pc sulla scena informatica dal 2002. Molti utenti si aspettavano questo, perché questo era quanto il mercato aveva prodotto finora.

Apple, invece, ha preferito estendere e utilizzare una sua tecnologia, per creare un nuovo prodotto estremamente importante. Importante non oggi, forse, ma tra dieci anni, quando il grosso dell’informatica di consumo sarà andato in questa direzione. La direzione è quella del mascheramento del filesystem all’utente, dell’autocontenimento dei file nelle applicazioni che li creano, senza più la necessità di scegliere dove salvare i file. Basta cartelle, basta file sparsi per il computer. Il seme di tutto ciò c’è già in Mac OS X, in due punti distinti: Spotlight ed iLife. Spotlight, grazie alla sua capacità di mostrare i risultati della ricerca in tempo reale, consente di ignorare dove si trovino i propri file (a volte anche come si chiamano, basta che si ricordi una parola di quanto c’è scritto), dato che tutto viene trovato all’istante. Con iLife, invece, Apple ci ha abituati a non preoccuparci del dove si trovino certi documenti (foto, filmati, musica, i progetti di iWeb). Sappiamo che possiamo accedere a quei file e manipolarli (organizzarli in album, raccolte, eventi, modificarli, fare progetti video) da dentro le applicazioni stesse, possiamo accedere grazie al Browser Media al contenuto delle librerie dei programmi di iLife senza dover aprire l’applicazione che gestisce quei file e possiamo, da dentro l’applicazione che ci interessa e direttamente da Mail, prendere le foto, la musica o filmati che ci servono ed allegarli ad un messaggio di posta elettronica.

Presentando iWork per iPad, Apple ha mostrato come i documenti creati con le tre applicazioni sono contenuti nelle app stesse e da lì possiamo mandarli via email come Pdf o nel loro formato nativo. Piano piano questi meccanismi saranno affinati, ci sarà sempre più cooperazione tra un’applicazione e l’altra, andando a colmare il gap di funzioni attualmente esistenti tra Mac OS X ed iPhone OS.

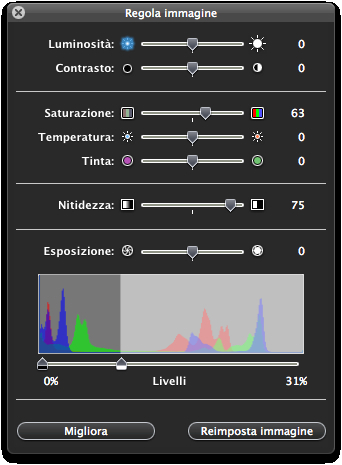

Pensate ad esempio, in Mac OS X, al servizio di regolazione delle immagini: quel pannello flottante che si apre in iPhoto, iWeb, Anteprima, iWork quando selezionate una figura e cliccate il tasto Regola. Quel pannello non è specifico di alcuna applicazione, ma è un servizio del sistema operativo stesso.

Immaginiamo ora questo concetto esteso ad iPhone OS. Ho delle immagini in Foto, accedo via Browser Media e ne aggiungo una in Pages. Se ho acquistato un applicazione per fare dell’editing sulle foto, allora posso toccare l’immagine in Pages e aprirla in quel programma per modificarla e quindi ritrovare le modifiche in Pages. Salvare non sarà più una necessità: uscire dall’applicazione o creare un nuovo documento farà si che le nostre modifiche siano registrate senza possibilità di perdere i dati.

Nel finire degli anni ’70, quando gli ingegneri dello Xerox PARC hanno cominciato a lavorare all’interfaccia grafica come sistema d’interazione tra l’utente ed il computer, il paradigma della Scrivania era sembrato il più coerente con l’utilizzatore tipo della nascente informatica: gli uffici e le segretarie, in particolare. Se pensiamo a come funzionano i computer, l’uso di documenti e cartelle in cui riporle, la segreteria appare l’utilizzatrice tipo: scrive i documenti per il capo e glieli passa o ripone in cartelle sugli scaffali dell’ufficio. L’uso del computer non è personale, ma è usato “per conto terzi”. I documenti non sono di chi li crea, dunque vanno organizzati in cartelle all’interno dell’ufficio.

Un utilizzo maggiormente personale, invece, ricalca l’uso di un bloc notes: prendo il bloc notes, scrivo, quando ho finito lo ripongo. Mettiamo che il bloc notes sia Pages. Dove lo ripongo è dove il programma è installato. Io utilizzo il bloc notes per scrivere, non devo preoccuparmi di dove riporre il foglio scritto, perché è dentro l’oggetto stesso. Questo è l’identico paradigma di iPhone OS: i documenti creati con una applicazione risiedono dentro l’applicazione stessa, andando a fondere il concetto del documento con quello del programma che lo gestisce.

Si potrebbe arrivare al concetto contrario: a sparire potrebbe essere l’applicazione come la conosciamo ora, a favore di moduli. Pensiamo di nuovo al bloc notes. Su quello io posso scrivere, ma posso anche disegnare, creare tabelle, eseguire calcoli, scrivere note musicali, ecc. Se invece di tante applicazioni specializzate avessimo un unico documento, sul quale poter attivare il modulo di scrittura, quello di disegno, aggiungere animazioni, scrivere note e farlo suonare, video, ecc? Invece che creare applicazioni singole, potrebbero essere creati dei moduli, delle estensioni alle funzionalità base della pagina. Un po’ come se imparassi a dipingere ad acquerello e cominciassi a farlo sul mio foglio del bloc notes, allo stesso modo potrei scaricare ed aggiungere un modulo per disegnare con differenti pennelli. Su un documento del genere potrebbero essere racchiuse le funzionalità che attualmente vengono eseguite separatamente dalle applicazioni iPhone Messaggi, Mail, Pages, Numbers, Keynote, Foto, Note.

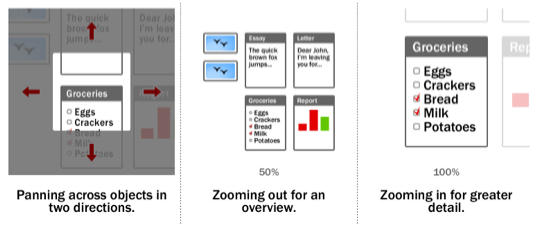

Una visione di questo tipo era sostanzialmente la tipologia d’interazione con la macchina che aveva in mente Jeff Raskin, ovvero il creatore del progetto Macintosh in Apple, che si era scontrato con Steve Jobs in merito a cosa il Mac dovesse diventare ed era uscito dall’azienda proprio perché contrario al modo in cui stava venendo gestita la sua creazione. Fuori da Apple Raskin ha creato la fondazione Raskin Center, per sviluppare lo studio di interfacce utente alternative a quelle basate sul paradigma della finestra, arrivando proprio ai moduli ed a una ZUI (Zoom User Interface), in cui non c’erano più finestre, ma un’unica schermata infinita all’interno della quale muoversi bidimensionalmente e avvicinarsi agli elementi che interessano o allontanarsi per vederli tutti insieme.

Ovviamente tutte queste possibili direzioni dell’interazione con i computer non avranno un riscontro ed un impatto immediato sul nostro uso dei personal computer; il concetto stesso di computer varierà dalla forma abituale d’oggi (schermo + case + tastiera e mouse) verso qualcosa di meno definito: iPhone già oggi è un Mac da tasca con interfaccia tattile, iPad estenderà questo concetto, ma il bello verrà con i prossimi 10/15 anni di sviluppo, sia hardware (per l’aumento di potenza e la miniaturizzazione che ci faranno avere “computer” sempre meno riconoscibili nella loro forma attuale) ma soprattutto software, in particolare per quanto riguarda le interfacce utente, che sono il modo più evidente e radicale con il quale si può cambiare la modalità con cui ci rapportiamo alle macchine.

Alcune letture interessanti per approfondire l’argomento ed avere una visione d’insieme delle trasformazioni che sono in atto:

Il vecchio ed il nuovo mondo dell’informatica – Traduzione a cura di Riccardo Mori di un articolo di Steven Frank.

The Humane Interface – Riassunto delle regole d’interfaccia elaborate da Jeff Raskin.

Articolo interessantissimo e ben scritto.Complimenti!

Quoto ogni parola, e mi complimento con l’autore, per come ha scritto questo magnifico articolo che twitterò subito. Uno dei miglior articoli che abbia mai letto!

Veramente molto bello, complimenti.

Grazie ragazzi!

Interessante, sopratutto la parte sull’User Interface. Ora capisco perchè il Courier con quel suo aspetto da Moleskine mi piace così tanto. In effetti se devo andare ad una conferenza (ma il concetto si può estendere anche alle scuole o al lavoro in genere) un computer è l’oggetto peggiore per prendere appunti e organizzare le idee. Da questo punto di vista l’iPad nonostante tutto per certi versi mi sembra ancora ancorato al retaggio desktop, un pennino non sarebbe male, non dico tornare ad usare esclusivamente quello, amo il multitouch, ma la tastiera dal punto di vista pratico è un compromesso al quale mi piacerebbe non dover arrivare, d’altronde scrivere con le dita lo trovo veramente scomodo.

molto interessante!!! lo rileggero sicuramente!

Jeff Raskin non uscì dall’azienda perché contrario al modo in cui stava venendo gestita la sua creazione, ma fu estromesso da Steve Jobs che alla fine lo relegò alla compilazione del manuale del Mac.

Il pannello per regolare i colori non è una funzione di sistema come erroneamente scritto nell’articolo, ma è specifico per ogni applicazione. Basta attivare quello di iPhoto e quello di Anteprima per renderesene conto. E poi ul pulsante Regola non esiste per Anteprima.

La butto lì: Mac OS XI sarà una rivoluzione in termini di interfaccia! Vi ricordate Minority report? Beh, credo che ci si stia avvicinando assai velocemente, e scommetto che sarà Apple ad arrivarci per prima ;)

P.s: secondo me a partire da Mac OS 10.7 comincerà a cambiare l’interfaccia, per abituare pian piano la gente ad un modo diverso di “vedere” il computer; e mi spingo oltre, dicendo che non è così strambo pensare che Apple abbia in testa il progetto di creare un sistema di riconoscimento vocale alquanto avanzato, per poter interagire ancor meglio con i computer (e non solo).

Che ne dite?

Fatemi capire: secondo voi un giorno non ci sarà bisogno di vedere le proprie cartelle e i proprio files ma sarà possibile usare solo spotlight?? Ma vi rendete conto che questo sarebbe un passo indietro rispetto a quando si usava solo il terminale? ALmeno lì con “ls” si vedevano le cartelle e i files, con spotlight nemmeno quelli! E se non ricordo come si chiama un file??

Secondo me l’ipad non sarà il futuro proprio per niente!

intotheapple.com

Leggendo quest’articolo mi viene da pensare che Mac OSX di fondo sia sbagliato…complimenti :)

io nel futuro vedo la parola microsoft e windows questo lo dico da fan apple perché ho notato che con tutta questa concorrenza redmond si sta risvegliando

Quanto mai ottimo articolo…a conferma che la strada intrapresa da Apple sia sempre più quella di delegare la gestione di files e cartelle al programma anzichè all’utente è confermato dall’assenza dell’icona “macintosh hd” all’avvio di Snow Leopard. Biosgna abilitarla dal Finder! E’ un piccolo segno del cambiamento. E gli altri dietro.

@ maxlaudadioodiolaudamax: Dici ? Io vedo sempre le solite cose, sempre le solite idee copiate, sempre le solite sparate di un Ballmer sempre più imbarazzante. Innovazione e qualità non abitano da quelle parti. Poi se parliamo di mercato…alzo le mani…c’è poco da fare.

@ lovecraft22:

sicuramente ci sarà qualcosa di estremamente diverso da ora, almeno per quanto riguarda l’interazione uomo macchina. Ovviamente i metodi si affineranno e non saranno come è ora iPhone OS, ma l’idea di mascherare il filesystem all’utente è sicuramente vincente.

Della dice:

anch’io avrei sperato nell’integrazione di un sistema di input come il pennino, non tanto per l’uso quotidiano, quanto per determinate applicazioni, come ad esempio Brushes…

Immaginatevi di usare il pennino nella destra e, con la sinistra, muovere uno slider per diminuire ed allargare la dimensione…

Come detto, iPad non è interessante in quanto prodotto fatto e finito, quanto per le possibilità che introduce in una sua diffusione a larga scala.

aggiornamento (minore, pare) skype

Stefano dice:

Io me ne sono reso conto con un anno di assistenze ma soprattutto di corsi e 121 in un APR italiano.

Mi son reso conto di come noi tecnici siamo una casta e spesso ci faccia comodo che la gente abbia bisogno di noi per risolvere i problemi dei loro computer o imparare ad usarlo, ma la realtà è che ci può essere un modo differente.

In fondo il computer dovrebbe aiutarmi a fare delle cose meglio ed in meno tempo, non è possibile dover sprecare un sacco di tempo ad imparare come deve essere usato o avere sempre la paranoia di toccare qualcosa che non deve essere toccata rischiando di perdere i miei documenti…

Leonardo dice:

io è da un po’ che sogno un finder a “libreria”, una sorta di database di file alla iPhoto…

@ Script:

Ti assicuro che è un servizio di sistema, solo che può essere più o meno specifico a seconda dell’applicazione. In iPhoto dove lavori sulle foto sono attive funzioni maggiormente dedicate alla fotografia.

Alla fine è lo stesso anche in iMovie ’09, solo che lavora su sequenze di frame invece che immagini statiche…

La suddivisione per concetti o gruppi dei file anche non omogenei è fondamentale, già si nota che la semplice archiviazione per genere non funziona, ad esempio iPhoto non solo suddivide i file per data ma anche per eventi ed anche per volti ed anche per luoghi.

E questo per un semplice uso non professionale, per un uso professionale devo poter suddividere per cliente o per data etc… in oltre a volte è necessario tenere raggruppati generi di file diversi file di testo con immagini o file musicali.

la mia esigenza non è di avere tutti i file di testo tutti assieme bensì è di avere file disomogenei raggruppati per lavoro…

Come me lo risolve sj questo problema non di sicuro togliendomi la piena gestibilita delle cartelle.

A parte questo sostengo che per un uso dilettantistico o domestico “da divano” l’ipad vada bene.

L’artiocolonè molto chiaro e lo dovrebbero leggere tutte quelle persone che ancora si chiedono a cosa serva l’iPad!

Bell’articolo!

Caro Emanuele un piccolo appunto al tuo articolo: dovresti citare la fonte da cui si trae “spunto” per un articolo anche se a dirla tutta stavolta mi è parso un vero e proprio copia e incolla. Proprio ieri mi è capitato di leggere l’originale (http://emaskew.blogspot.com/2010/03/ipad-il-futuro-del-computing.html).

Un saluto

Apprendo ora che il blog che ho citato prima sei tu stesso a gestirlo. Errore mio!

http://www.matteolucatello.it/il-futuro-dellipad/